Google pochwaliło się nową technologią rekonstrukcji obrazów w aplikacji Zdjęcia. Ujęcia nawet po zaawansowanej edycji zachowają format HDR. Nowość skierowana jest do wybranych smartfonów z serii Pixel.

Uczenie maszynowe w Pixelach zadba o zdjęcia

Zdjęcia Google to popularne narzędzie, w którym nie tylko zgromadzimy i przechowamy nasze ujęcia, ale także je ulepszymy. Technologiczny gigant z Mountain View sukcesywnie uzupełnia listę funkcji w aplikacji Zdjęcia i coraz częściej opiera nowości o sztuczną inteligencję. Teraz pokazał nową technikę złożonej edycji obrazów HDR, korzystającą z uczenia maszynowego (ML).

Zdjęcia wykonywane z użyciem HDR charakteryzują się zakresem jasności porównywalnym do zakresu, jakie może zobaczyć człowiek. Google w 2023 roku opracował nowy format – Ultra HDR, dzięki któremu zdjęcia z Pixeli 7 są jeszcze bardziej realistyczne w porównaniu do SDR. O ile smartfony są w stanie wykonywać zdjęcia z użyciem tej technologii, o tyle problem pojawia się, gdy dane ujęcie jest edytowane. Jeśli np. zdecydowałeś się na użycie złożonej funkcji, takiej jak np. Magic Eraser, Twój obraz zapisywany jest w formacie SDR. Oznacza to, że grafika traci odwzorowanie HDR wraz z kontrastem i jasnością.

Dlatego też przedsiębiorstwo opracowało technikę uczenia maszynowego, dzięki której problem ma zostać zażegnany, a zmienione obrazy nadal pozostaną w formacie HDR. Nowość ma działać w aplikacji Zdjęcia Google na smartfonach Pixel 8 i nowszych.

Jak działa nowa technologia w aplikacji Zdjęcia Google?

O ile wykonanie prostych czynności edycyjnych na zdjęciach, takich jak przycinanie czy obracanie, nie powoduje zapisywania obrazów do formatu SDR, o tyle użycie zaawansowanych funkcji typu Magiczna Gumka czy Magiczny Edytor już tak. Dzieje się tak dlatego, że narzędzia te zostały opracowane właśnie dla grafik w formacie SDR jako wejściowych, a co za tym idzie – również wyjściowych.

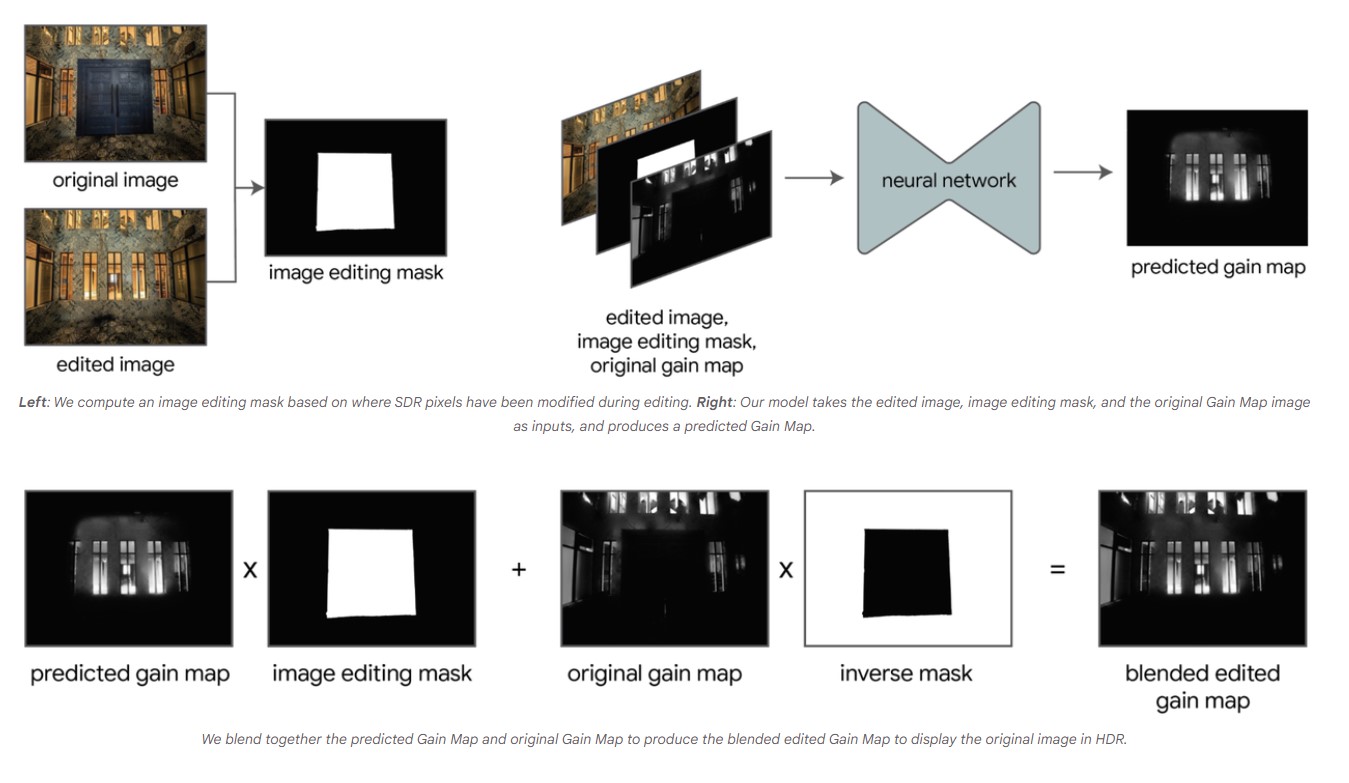

Google znalazło jednak sposób, aby pokonać ten problem. Nowy model uczenia maszynowego jest odpowiedzialny za zrekonstruowanie brakujących regionów w zakresie tzw. mapy wzmocnienia. W oparciu o zdjęcie oryginalne i edytowane, uczenie maszynowe oblicza maskę edycji na podstawie pikseli SDR. Dodatkowo model w oparciu o edytowany obraz, otrzymaną maskę i oryginalną mapę wzmocnienia przewiduje nową mapę wzmocnienia. Połączenie jej z maską edycji i oryginalną mapą wzmocnienia pozwala na wygenerowanie obrazu w formacie HDR. Aby łatwiej było zrozumieć zachodzący proces warto spojrzeć na poniższą grafikę.

Otrzymany model został wytrenowany na kilku tysiącach obrazów HDR. Rekonstrukcja mapy wzmocnienia zajmuje mniej niż 1 MB. Według informacji przekazanych przez Google żadne z funkcji edycji, które wykorzystują do działania uczenie maszynowe, nie wymaga niestandardowych przepływów pracy i ma sprawdzić się dla każdego efektu edycyjnego (również w przyszłości dla funkcji, które jeszcze nie powstały).

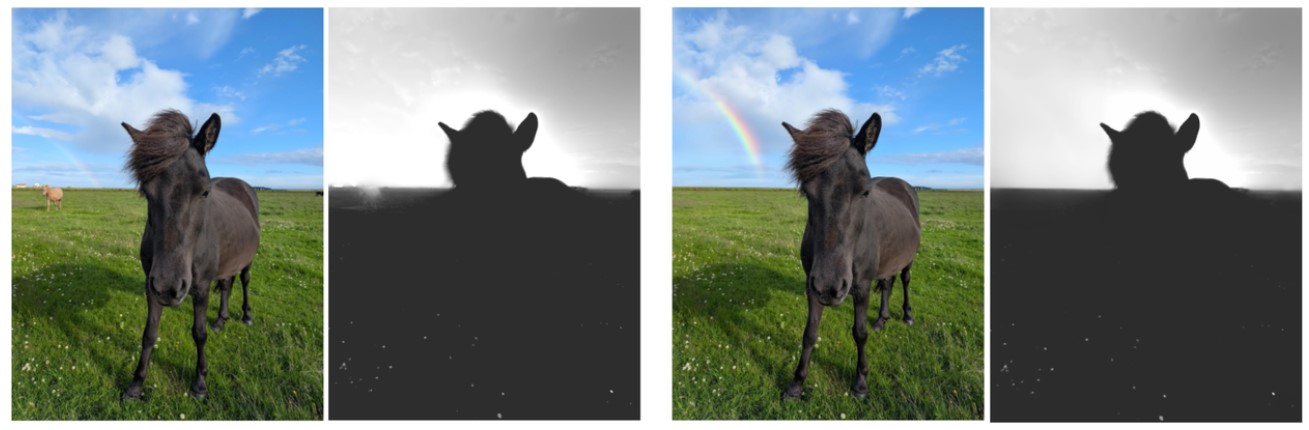

Technologiczny gigant udostępnił galerię obrazów HDR, gdzie można przyjrzeć się fotografiom przed i po rekonstrukcji, wykonanych za pomocą nowego modelu.