Nie ulega żadnej wątpliwości, że przyszłość należy do Sztucznej Inteligencji. Wszyscy giganci branży technologicznej bardzo mocno w nią inwestują i powoli nawet wdrażają na rynek „uzbrojone” w nią rozwiązania. Wiele jednak jeszcze wody w rzece upłynie, zanim wszędobylska obecność AI będzie dla większości osób zupełnie naturalna, ponieważ po raz kolejny okazuje się, że na obecnym etapie rozwoju nie jest ona wcale taka „inteligentna” i dość łatwo ją „ogłupić”.

Sztuczna Inteligencja bez wątpienia jest ciekawym „tworem”, lecz praktyka wielokrotnie pokazała, że często bywa ona nieprzewidywalna. Co prawda daleki jestem od obaw, że AI kiedyś stanie się na tyle inteligentna, że postanowi unicestwić ludzkość, ale przypadek Tay autorstwa Microsoftu pokazał, że wystarczy chwila nieuwagi i skutki będą opłakane. Nie jest to jednak jedyna sytuacja, w której Sztuczna Inteligencja nie pokazała się od najlepszej strony.

Jedną z bardziej popularnych i przydatnych z punktu widzenia przeciętnego użytkownika funkcji AI jest rozpoznawanie tego, co znajduje się na zdjęciach, obrazach, grafikach itd. Sztuczna Inteligencja radzi sobie już całkiem nieźle z tym zdaniem, chociaż oczywiście zdarza jej się strzelić jakiegoś babola. Badacze z Google postanowili sprawdzić, jak wiele potrzeba, aby strollować AI.

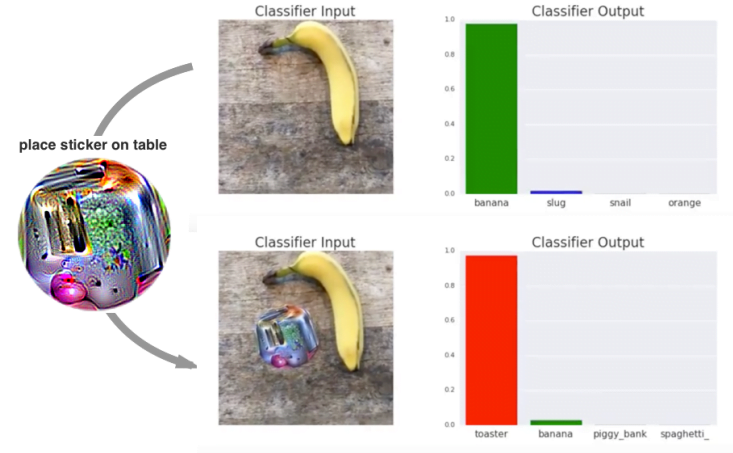

Cóż, okazało się, że całkiem niewiele. Na pierwszy ogień poszło zdjęcie banana. Algorytmy bez problemu rozpoznały, że to właśnie ten owoc znajduje się na fotografii. Wystarczyło jednak dodać stworzoną w specjalny sposób „naklejkę”, aby Sztuczna Inteligencja dosłownie „zgłupiała”. W drugim przypadku AI niemal całkowicie bowiem pominęła banana i stwierdziła, że na zdjęciu jest przede wszystkim… toster.

Jakie wnioski płyną z doświadczeń ekipy z Google? W pierwszej chwili wydawać by się mogło, że to kolejna ciekawostka. Tymczasem – kiedy zdamy sobie sprawę, jak wiele zastosowań może mieć (i już ma) Sztuczna Inteligencja – okaże się, że z pozoru nic nie znaczące „naklejki” mogą być groźną bronią w walce z AI.

Wyobraźcie sobie bowiem taką sytuację: jesteście w jakimś miejscu na świecie, gdzie algorytmy na bieżąco monitorują każdego przechodnia, aby wyłapać potencjalnie niebezpieczne jednostki (na przykład terrorystów czy innych przestępców). Ktoś, kto ma niecne zamiary, na pewno o tym wie i z chęcią stałby się zupełnie anonimowy – może to mu umożliwić taka właśnie naklejka.

Plus jest jednak taki, że to nie jest byle jaki, pierwszy z brzegu „psychodeliczny” obrazek, lecz odpowiednio zmodyfikowana grafika. Przeciętny użytkownik na 99% takiej samodzielnie nie stworzy, ponieważ nie ma niezbędnej do tego wiedzy. Co bardziej „rozgarnięci” przestępcy mogą sobie jednak już w tym poradzić. I tutaj pojawia się problem.

Powyższy przykład pokazuje, że to właśnie tego typu „manewrów” powinniśmy się obawiać, a nie utopijnej wizji zniszczenia ludzkości przez Sztuczną Inteligencję.

Źródło: Google przez TechChrunch