Smartfony Google Pixel, choć w Polsce nie są sprzedawane w oficjalnej dystrybucji, zyskały całkiem spore grono zwolenników. Nic dziwnego więc, że interesuje nas to, co producent zamierza zmienić w następnej generacji swoich kieszonkowych urządzeń. Oto, czym będziemy robić zdjęcia w serii Pixel 8.

Fotograficzny rozwój

Jeśli kiedykolwiek użytkowaliśmy telefon z serii Pixel, jedno raczej przyznamy: Google naprawdę potrafi sprawić, że zdjęcia, które robią te telefony, wyglądają ładnie. Pamiętam, jak Pixelem 3a z jednym obiektywem robiłem lepiej prezentujące się fotki niż sprzętami za dwukrotnie większe pieniądze.

Google od czasu Pixela 6 korzysta jednak z tej samej matrycy aparatu, ulepszając jedynie możliwości oprogramowania. Przyszedł czas, by porzucić wysłużony już sensor Samsung ISOCELL GN1 i zamienić go na lepszy model. I właśnie na to liczymy w Pixelu 8.

Pixel 8 z nowym zestawem aparatów

Kolejny flagowiec Google nie będzie się znacząco różnił od aktualnych topowych smartfonów tego producenta – przynajmniej z wyglądu. Jak dotąd, mieliśmy już możliwość podejrzeć design Pixela 8 i nie ma się co nastawiać na rewolucje. Obudowa zostanie nieco wygładzona, by zyskać tu i ówdzie na wygodzie podczas użytkowania, ale sam styl i projekt pozostanie z grubsza taki sam.

Tyczy się to przede wszystkim wyglądu tylnego panelu, gdzie na odcinającym się większą grubością szerszym pasku, będą ulokowane obiektywy aparatów oraz pozostałe sensory (w tym termometr w wersji Pro).

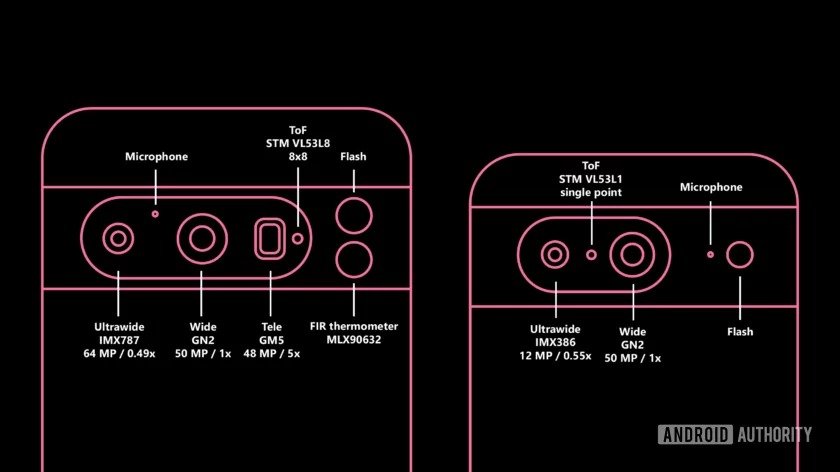

Główna aktualizacja zestawu fotograficznego będzie się tyczyć zamiany matrycy Samsung ISOCELL GN1 na ISOCELL GN2. Nowy sensor zbierze nawet 35% więcej światła, więc uzyskamy jaśniejsze zdjęcia w gorszych warunkach oświetleniowych. Nie straszne mu też kręcenie wideo w 8K przy 30 kl./s. Sprzęt będzie również obsługiwać Staggered HDR, czyli technologię zmniejszającą opóźnienie między przechwytywania klatek dla trybu HDR.

Szerokokątny aparat także zyska ulepszenie – i to spore. Wysłużony 12-megapikselowiec Sony IMX386 zostanie zastąpiony przez matrycę Sony IMX787, czyli tą samą, który trafiła do Pixela 7a, przy czym w średniopółkowcu pełni ona funkcję głównej matrycy, a nie pomocniczej.

I jest jeszcze ultraszerokokątny obiektyw, który co prawda polega na współpracy z matrycą IMX386 (znaną z Pixela 6), ale „szkiełko” zostało nieco zmodyfikowane. Współczynnik powiększenia Pixela 7, wynoszący 0,67x, ma zostać „rozciągnięty” do 0,55x.

Dokładne zmiany względem aktualnej generacji ukazuje poniższa tabela z danymi zebranymi przez Android Authority, jako że Google zaprezentuje przecież zarówno smartfon Pixel 8, jak i mocniejszego Pixela 8 Pro.

| Pixel 7 | Pixel 8 | Pixel 7 Pro | Pixel 8 Pro | |

| Aparat główny | Samsung GN1 (50 Mpix) | Samsung GN2 (50 Mpix) | Samsung GN1 (50 Mpix) | Samsung GN2 (50 Mpix) |

| Obiektyw ultraszerokokątny | Sony IMX386 (12 Mpix) – współczynnik powiększenia 0,67x | Sony IMX386 (12 Mpix) – współczynnik powiększenia 0,55x | Sony IMX386 (12 Mpix) – współczynnik powiększenia 0,56x | Sony IMX787 (64 Mpix) – współczynnik powiększenia 0,49x |

| Teleobiektyw | brak | brak | Samsung GM5 (48 Mpix) – zoom 5x | Samsung GM5 (48 Mpix) – zoom 5x |

| Aparat przedni | Samsung 3J1 (11 Mpix) | Samsung 3J1 (11 Mpix) | Samsung 3J1 (11 Mpix) | Samsung 3J1 (11 Mpix) |

Jak widać, różnice między wersją podstawową, a opcją Pro będzie jeszcze większa niż obecnie. A do tego Pixel 8 Pro ma zyskać inny sensor ToF, dla jeszcze lepszego i szybszego ustawiania ostrości.

Jak dotąd, za autofocus w kolejnych modelach Pixeli odpowiedzialny był czujnik STMicroelectronics VL53L1. Natomiast kolejny flagowiec Google zyska ulepszony sensor 8×8 ToF VL53L8.

Za zmianami czysto sprzętowymi mają też podążać ulepszenia software’owe. Producent zastosuje funkcję Adaptive torch, która pomaga unikać prześwietlania zdjęć, co przyda się też podczas pracy z użyciem lampy błyskowej. Inną nowością będzie Segmentacja AWB, działająca dzięki sztucznej inteligencji. Algorytmy będą rozpoznawać poszczególne fragmenty sceny, by selektywnie zarządzać różnymi kawałkami obrazu.

Bardzo ciekawi nas, jak Google wykorzysta potencjał nowego sensora i czy ujarzmi algorytmy wspierające procesowanie obrazu. Jak do tej pory, udawało się to naprawdę nieźle.