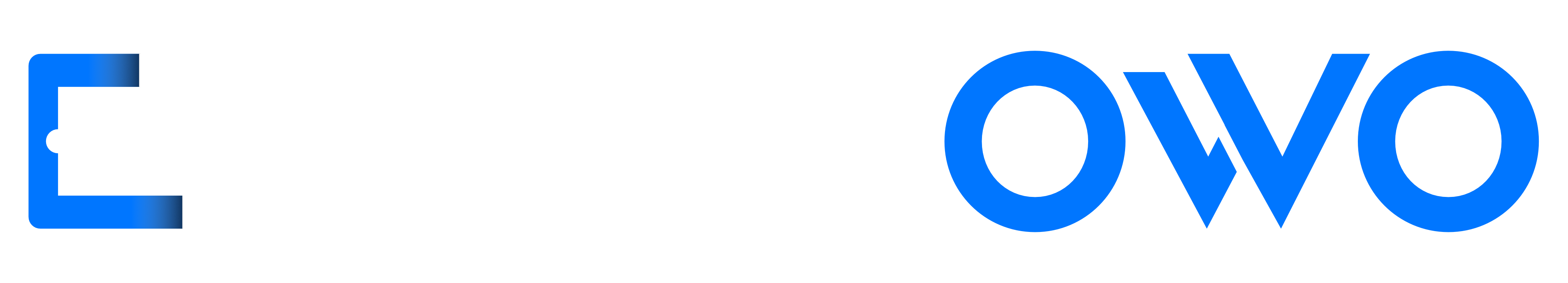

Użytkownicy smartfonów z Androidem mają różne oczekiwania i potrzeby. Przy okazji Global Accessibility Awareness Day (Światowego Dnia Świadomości Dostępności) Google ogłosiło nowe funkcje w swoich aplikacjach i usługach, stworzone z myślą o osobach o specjalnych potrzebach.

Dzięki tym ułatwieniom korzystanie ze smartfona z Androidem będzie łatwiejsze dla osób, które mają szczególne potrzeby

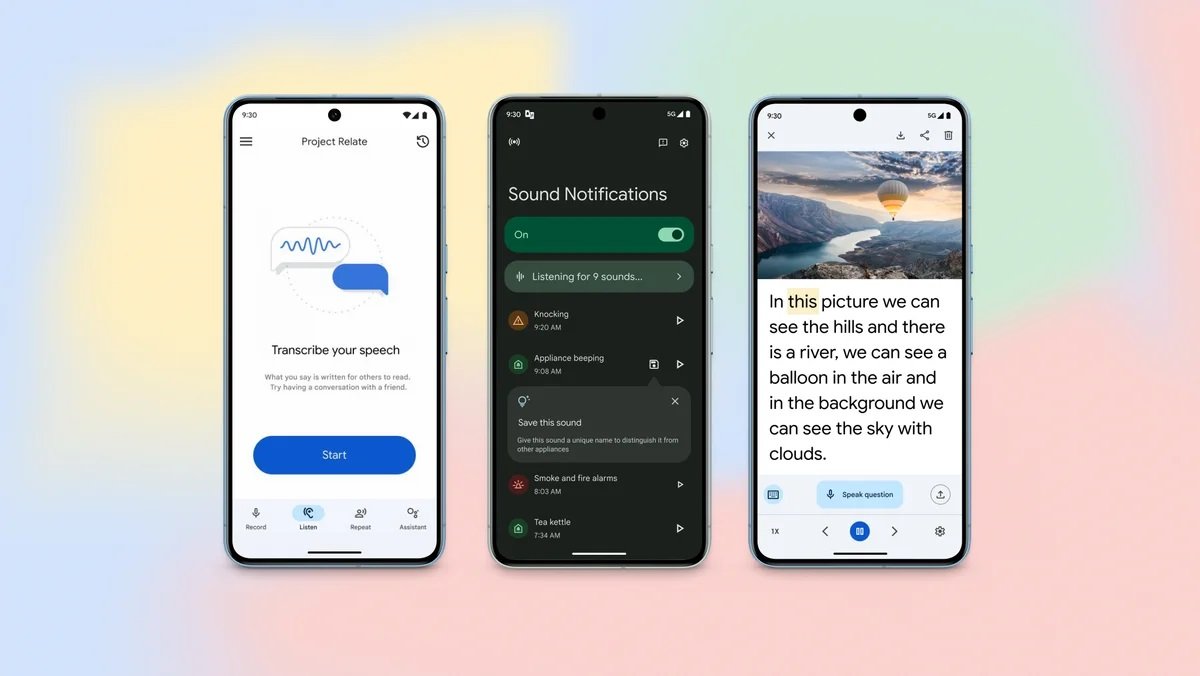

Pierwsza z aktualizacji dotyczy aplikacji Lookout, skierowanej do osób niewidomych i słabowidzących. Dziś udostępniono w niej nowy tryb Find, który zapewnia nowy sposób znajdowania określonych obiektów. Użytkownik ma do wyboru siedem kategorii przedmiotów, na przykład siedzenia i stoły oraz łazienki. Po wybraniu odpowiedniego wystarczy kierować smartfon w różne strony dookoła siebie – gdy program zidentyfikuje w obiektywie kwalifikujący się obiekt, powiadomi o odległości, w jakiej się znajduje i w jakim kierunku musi podążać użytkownik.

Ponadto od teraz, gdy zrobi on zdjęcie z wykorzystaniem aplikacji Lookout, sztuczna inteligencja wygeneruje jego opis. Jest to rozwinięcie niedawno dodanej funkcji, dostępnej globalnie w języku angielskim, która z pomocą AI generuje opis tego, co znajduje się na obrazie.

Kolejna aktualizacja związana jest z aplikacją Look to Speak. Dziś został w niej udostępniony nowy tryb bez tekstu (text-free mode), w którym można wybierać i personalizować emotikony, symbole i zdjęcia, aby aktywować mowę. Google informuje, że funkcja ta została opracowana jako odpowiedź na informacje zwrotne społeczności.

Z okazji Global Accessibility Awareness Day firma z Mountain View udostępniła również deweloperom możliwość wykorzystania Project Gameface na urządzeniach z Androidem. Dzięki temu mogą oni stworzyć aplikacje, które pozwolą użytkownikom dostosowywać mimikę twarzy, wielkość gestów, szybkość kursora i nie tylko. Do tej pory był on dostępny wyłącznie na PC. Rozwiązanie to służy do nawigowania bez użycia rąk.

Nowości w Mapach dla osób niepełnosprawnych

Firma z Kalifornii poinformowała, że od dziś dostępne są na całym świecie we wszystkich obsługiwanych językach funkcje związane ze szczegółowymi wskazówkami głosowymi i Obiektywem w Mapach. Co ważne, dotyczy to nie tylko użytkowników smartfonów z Androidem, ale też iPhone’ów. Dzięki możliwości czytania zawartości ekranu w Obiektywie użytkownik usłyszy nazwę i kategorię miejsc oraz obiektów dookoła (na przykład bankomat, restauracja lub przystanek), a także otrzyma informację, jak daleko od nich się znajduje.

Z kolei szczegółowe wskazówki głosowe zapewniają monity dźwiękowe, które informują użytkownika, kiedy zmierza we właściwym kierunku albo przekracza ruchliwe skrzyżowanie. Ponadto zostanie przekierowany, jeśli zacznie podążać w złym kierunku.

Od teraz w Mapach na komputerach wyświetlana będzie też ikona ♿, która informuje, że dane miejsce jest dostosowane do potrzeb osób, poruszających się na wózkach inwalidzkich. Do tej pory była ona wyświetlana wyłącznie na urządzeniach z systemami operacyjnymi Android i iOS. Oprócz tego na urządzeniach mobilnych pojawiła się funkcja, umożliwiająca przefiltrowanie recenzji, aby łatwiej było znaleźć przydatne informacje na temat dostępności dla wózków inwalidzkich.

Nie zapomniano również o osobach, które mają problemy ze słuchem. Od dziś właściciele firm mogą dodać do swoich profili biznesowych w Mapach atrybut Auracast. Technologia ta umożliwia miejscom publicznym nadawanie ulepszonego lub wspomagającego dźwięku gościom korzystającym z aparatów słuchowych, słuchawek dousznych i słuchawek obsługujących Auracast.