To, że Meta cały czas pracuje nad rozwijaniem swojej sztucznej inteligencji, nie jest niczym zaskakującym i nowym. W przeciwieństwie do efektów Meta Movie Gen, które mogą szokować entuzjastów AI. Co potrafi najnowszy model do tworzenia wideo i czy faktycznie jest to spory przeskok pod względem jakości?

Meta Movie Gen to AI do wideo

Meta pracuje nad sztuczną inteligencją już od wielu lat i nie jest żadną tajemnicą, że AI działa w ramach platform społecznościowych tej firmy. Co więcej, użytkownicy mogą skorzystać z „Meta AI”, o ile ta usługa jest dostępna w ich kraju (w Polsce nie jest). Meta AI pomaga m.in. marketerom w tworzeniu lepszych reklam czy też zwykłym ludziom przy układaniu np. planu treningowego pod przygotowania do maratonu (zupełnie inną sprawą jest to, jakiej jakości są te plany treningowe).

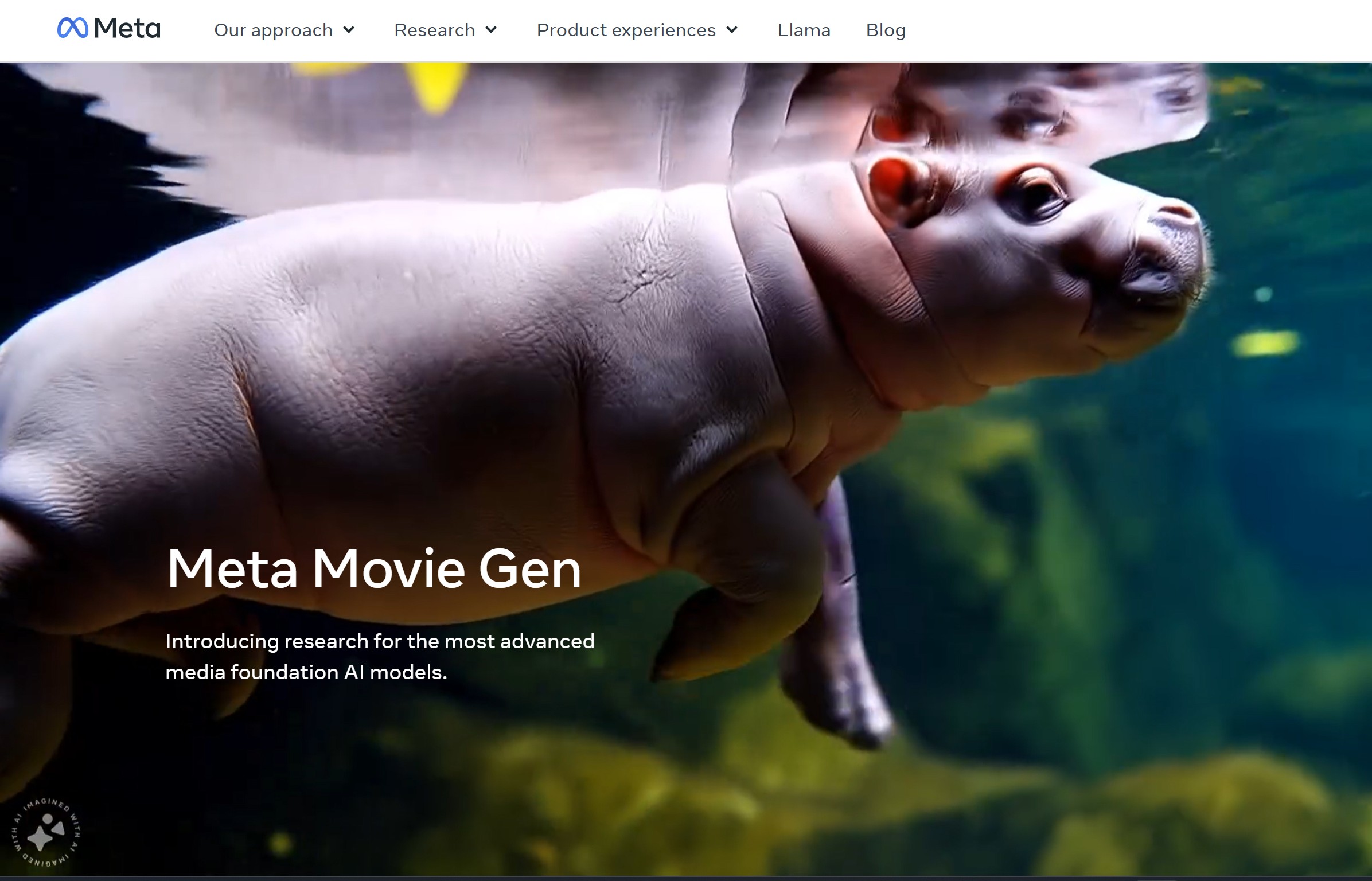

Teraz Meta postanowiła pójść o krok dalej i wytrenowała generatywny model do tworzenia wideo o wdzięcznej nazwie „Meta Movie Gen„. To AI może tworzyć realistyczne filmy z muzyką oraz efektami dźwiękowymi w 16 lub 24 klatkach na sekundę w rozdzielczości 1080p przeskalowanej z 768 x 768. Specyfikacja techniczna tych filmów nie jest więc niczym wybitnym, ale te wyglądają całkiem nieźle.

Zobaczcie zresztą kadr z takiego wideo:

Jak działa Meta Movie Gen?

Na razie wygląda na to, że w Polsce zbyt szybko nie będziemy mogli korzystać z tego rozwiązania. Na razie jest ono „badaniem” i nie jest dostępne publicznie, a jak już się pojawi, to zapewne najpierw w USA. Niemniej prawdopodobnie prędzej czy później zadomowi się ono na stałe w Unii Europejskiej, więc warto poznać to, jak działa.

Za pomocą prostych promptów możemy wygenerować wideo od zera lub zedytować już istniejące, nagrane smartfonem na potrzeby publikacji w Social Media czy wysłania do najbliższych. Wystarczy np. napisać „dodaj do filmu kaktusy na pustyni”, a te pojawią się w filmie. Im lepszy prompt, tym lepszy będzie efekt końcowy.

Z kwestii technicznych to trzeba podkreślić, że Meta Movie Gen jest zasilany przez transformator z 30 miliardami parametrów, a wygenerowane filmy w 16 klatkach na sekundę mogą trwać do 16 sekund (10 sekund w przypadku 24 klatek na sekundę).

Model audio, który z nim współpracuje, ma 13 miliardów parametrów i może utworzyć materiał trwający do 45 sekund. Podkład do filmu ma być od razu z nim zsynchronizowany, co jest świetną sprawą. Meta twierdzi również, że „model był szkolony na połączeniu licencjonowanych i publicznie dostępnych zbiorów danych”, ale dobrze wiemy, jak to jest z trenowaniem tych modeli przez gigantów… ;)