Tworzenie obrazów przy pomocy sztucznej inteligencji to codzienność dla wielu z nas. Możliwości, które kiedyś miały tylko najpotężniejsze superkomutery, drzemią teraz w każdym smartfonie. Jak więc rozpoznawać deepfake’i?

Deepfake czy nie deepfake – oto jest pytanie

Im bardziej zaawansowanymi narzędziami dysponują oszuści, tym łatwiej jest im tworzyć fałszywe zdjęcia i filmy, przedstawiające sławne osoby w okolicznościach, w których nigdy się one nie znalazły. Tego typu materiały rozchodzą się w Internecie z prędkością błyskawicy.

Niektóre grafiki i klipy powstają w celach czysto humorystycznych i wystarczy chwila, byśmy zorientowali się, że przedstawione elementy obrazu nie zgrywają się ze sobą. Część z takich prac jest wręcz komicznie groteskowa, więc nie mamy trudności, by orzec, że oto mamy do czynienia z wypaczeniem rzeczywistości lub kompletną fikcją. Gorzej, kiedy deepfake jest realistyczny i na przykład przedstawia jakąś sławną osobę. Jak stwierdzić, czy mamy do czynienia ze zdjęciem prawdziwego człowieka?

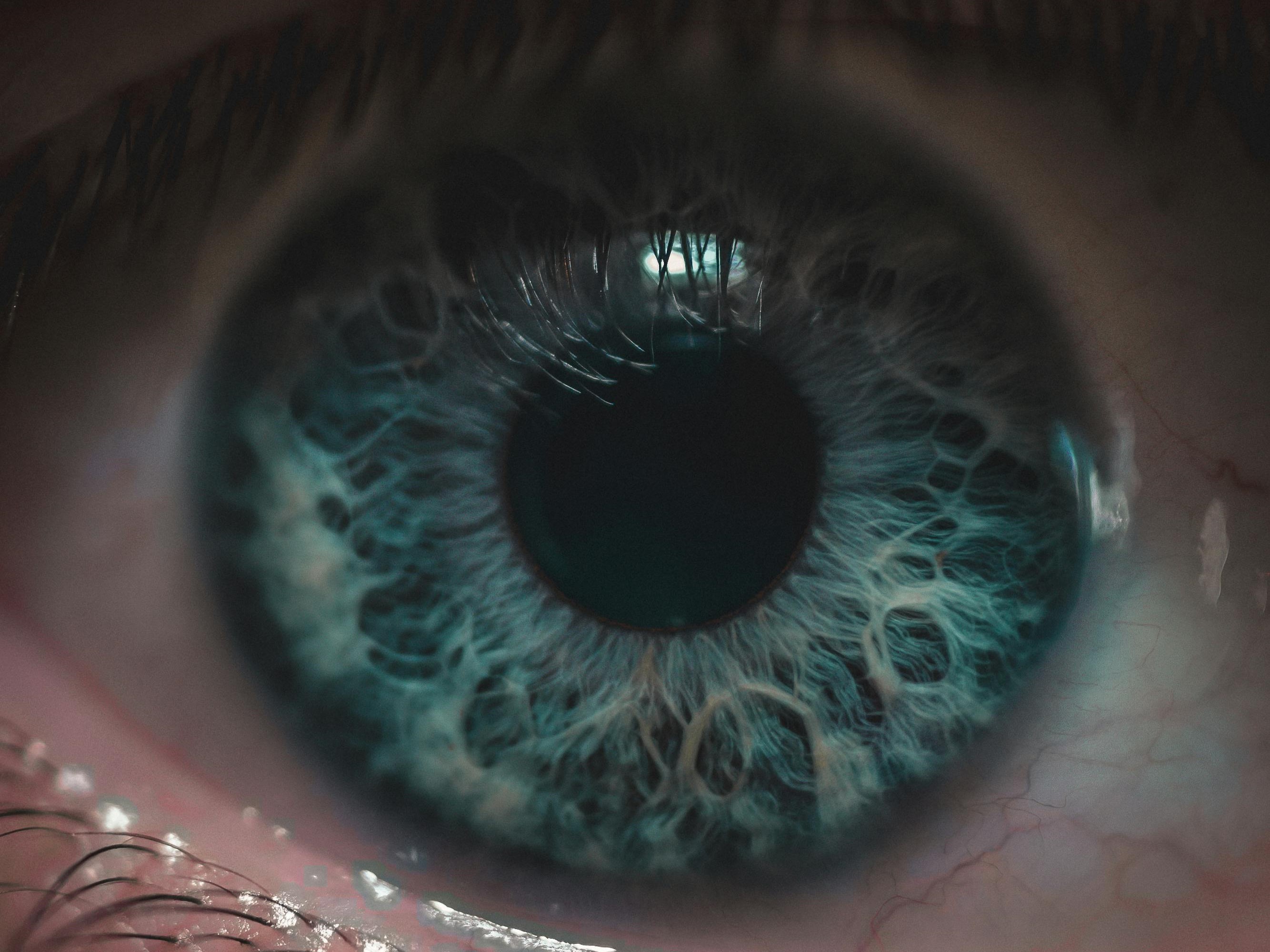

Popatrz androidowi w oczy

Okazuje się, że całkiem niezłym sposobem, by rozpoznać, czy mamy przed sobą fałszywy obraz, jest przyjrzenie się oczom danego człowieka ze zdjęcia lub filmu – o ile jego wzrok skierowany jest „w stronę kamery”.

Być może niektórym nasunie się tu skojarzenie z filmu Łowca androidów, gdzie w jednej z początkowych scen zaprezentowano działanie maszyny pomagającej określić prawdziwe pochodzenie indywiduum podającego się za człowieka. Aparatura była wyposażona w czujnik, który sprawdzał źrenice badanego obiektu, by pomóc w wykrywaniu emocjonalnych reakcji typowych dla ludzi. Maszyny, choć wizualnie nieodróżnialne od ludzkich postaci, mogły być na tym etapie rozpoznane.

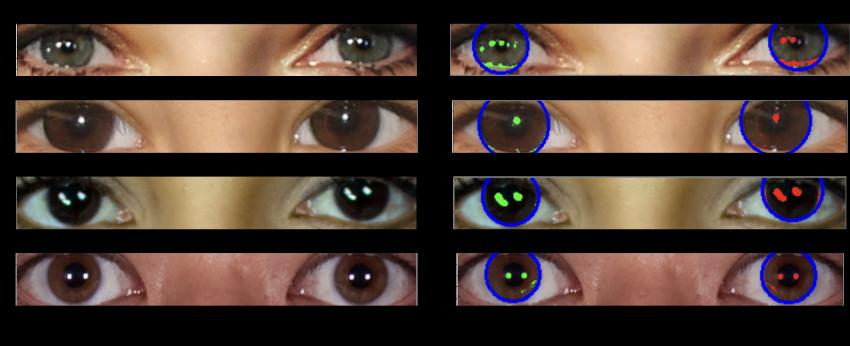

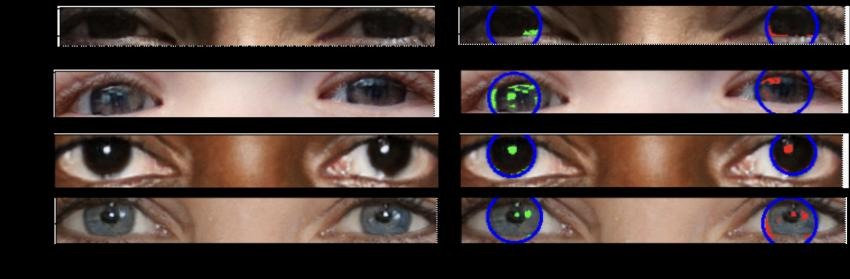

To oczywiście fikcja, a jak to działa w rzeczywostości? Ciekawym odkryciem podzielono się na spotkaniu Royal Astronomical Society’s National Astronomy w Hull. Sugeruje ono, że generowane przez AI fałszywe obrazy można wykryć, analizując ludzkie oczy, które się na tych obrazach pojawiają. I że proces badawczy jest podobny do analizowania zdjęć galaktyk przez astronomów. Najważniejszym jego elementem jest przyjrzenie się odbiciom w gałkach ocznych człowieka.

Jak wytłumaczył profesor astrofizyki Kevin Pimbblet, odbicia w gałkach ocznych są spójne dla prawdziwej osoby, ale nieprawidłowe (z punktu widzenia fizyki) dla wygenerowanej postaci. W uproszczeniu AI, tworząc obraz czyjejś twarzy lub próbując ją imitować, „nie pamięta”, by te odbicia w obu oczach były takie same. Jak to się ma do astronomii?

„Aby zmierzyć kształty galaktyk, analizujemy, czy są one centralnie zwarte, czy są symetryczne i jak gładkie. Analizujemy rozkład światła” — powiedział profesor Pimbblet. Ta sama metoda sprawdza się w wyszukiwaniu podobieństw i rozbieżności na obrazach przedstawiających ludzi.

Niestety, choć metoda ta wydaje się być skuteczna, na pewno nie jest niezawodna. Podczas testowania jej, pojawiały się pomyłki. Nie zyskaliśmy więc narzędzia ostatecznego, które zawsze wskazywałoby, czy mamy do czynienia z fałszywym klipem wideo czy zdjęciem. W miarę rozwoju technologii, będzie to zapewne jeszcze trudniejsze. Zupełnie jak dla Ricka Deckarda, który musiał umieć rozpoznawać, czy ma przed sobą androida, czy człowieka…