Sztuczna inteligencja była głównym przedmiotem deweloperskiej konferencji Google I/O 2024. Wygląda na to, że Gemini, czyli opracowane przez firmę AI, będzie teraz przenikać do wielu usług giganta z Mountain View.

Google i jego sztuczna inteligencja

Google nie stać na to, by zbagatelizować wielką falę zmian zapoczątkowaną przez OpenAI, które przeprowadziło małą rewolucję, udostępniając powszechnie swój produkt w postaci generatywnej sztucznej inteligencji ChatGPT. OpenAI było nawet na tyle śmiałe, by przedstawić najnowsze aktualizacje dla modelu GPT-4 na dzień przed konferencją Google. I cóż – narobiło trochę szumu.

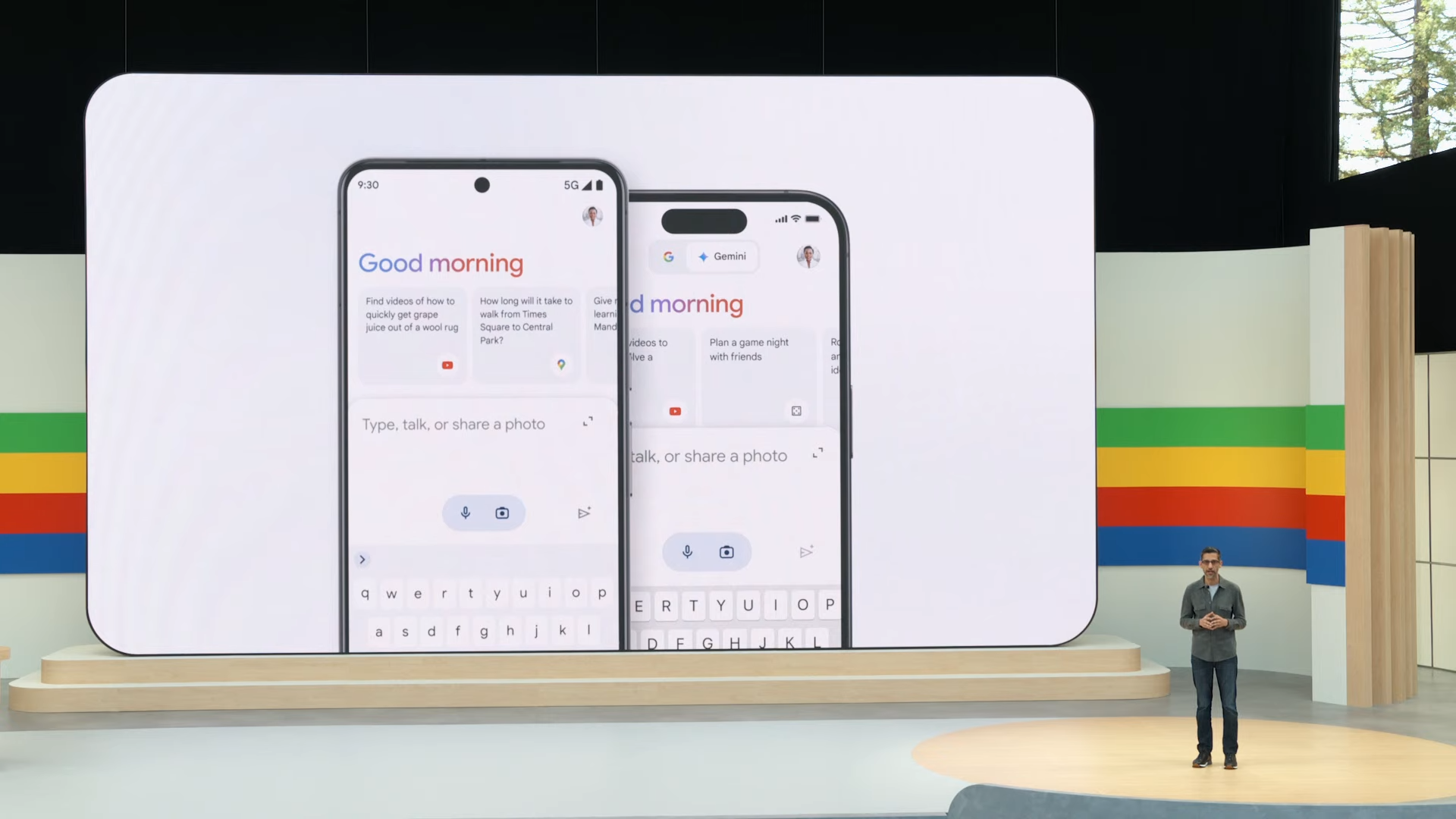

Gemini to model AI, którego wcześniej używano pod nazwą Bard. Jak na razie to właściwie oddzielny produkt, ale już niedługo. Google ogłosiło, że już niebawem Gemini stanie się integralną częścią wyszukiwarki – przynajmniej w Stanach Zjednoczonych i anglojęzycznych krajach. Ciekawostką jest to, że tak jak obecnie można wyszukiwać rzeczy tekstowo i przy pomocy zdjęć, Gemini będzie w stanie przeszukiwać sieć za pomocą wideo – i to jeszcze w tym roku. Czy w Polsce? Hm, zobaczymy.

Sztuczna inteligencja stanie się też elementem różnych aplikacji i usług. Polecenia głosowe będą mogły być wydawane aplikacji Zdjęcia Google, by przeszukać naszą bibliotekę, jeśli zapomnimy jakiegoś dokumentu czy zapisu. Nie będzie trzeba robić tego ręcznie.

Podobne możliwości zyska Gmail. Usługa połączona z Gemini będzie mogła na przykład podsumować wszystkie maile dotyczące jednego tematu, przedstawiając użytkownikowi najważniejsze informacje w przystępnej formie. Własne usprawnienia, razem z bocznym panelem pomocniczym otrzymają programy Workspace, w tym Meet (zapewne też i po Polsku, skoro zakres językowy określono na 68).

Gemini zyskuje ponadto ulepszone wersje swojego modelu: opcja 1.5 Pro została udostępniona dla wszystkich programistów i zaawansowanych użytkowników w ponad 35 językach – także po polsku. Edycja 1.5 Flash przeznaczona jest do bardziej podstawowych zastosowań i nie będzie obsługiwać tak dużej liczby tokenów jak najwyższy Pro. Obie dostępne będą dla deweloperów z ponad 200 krajów, w różnych poziomach cenowych.

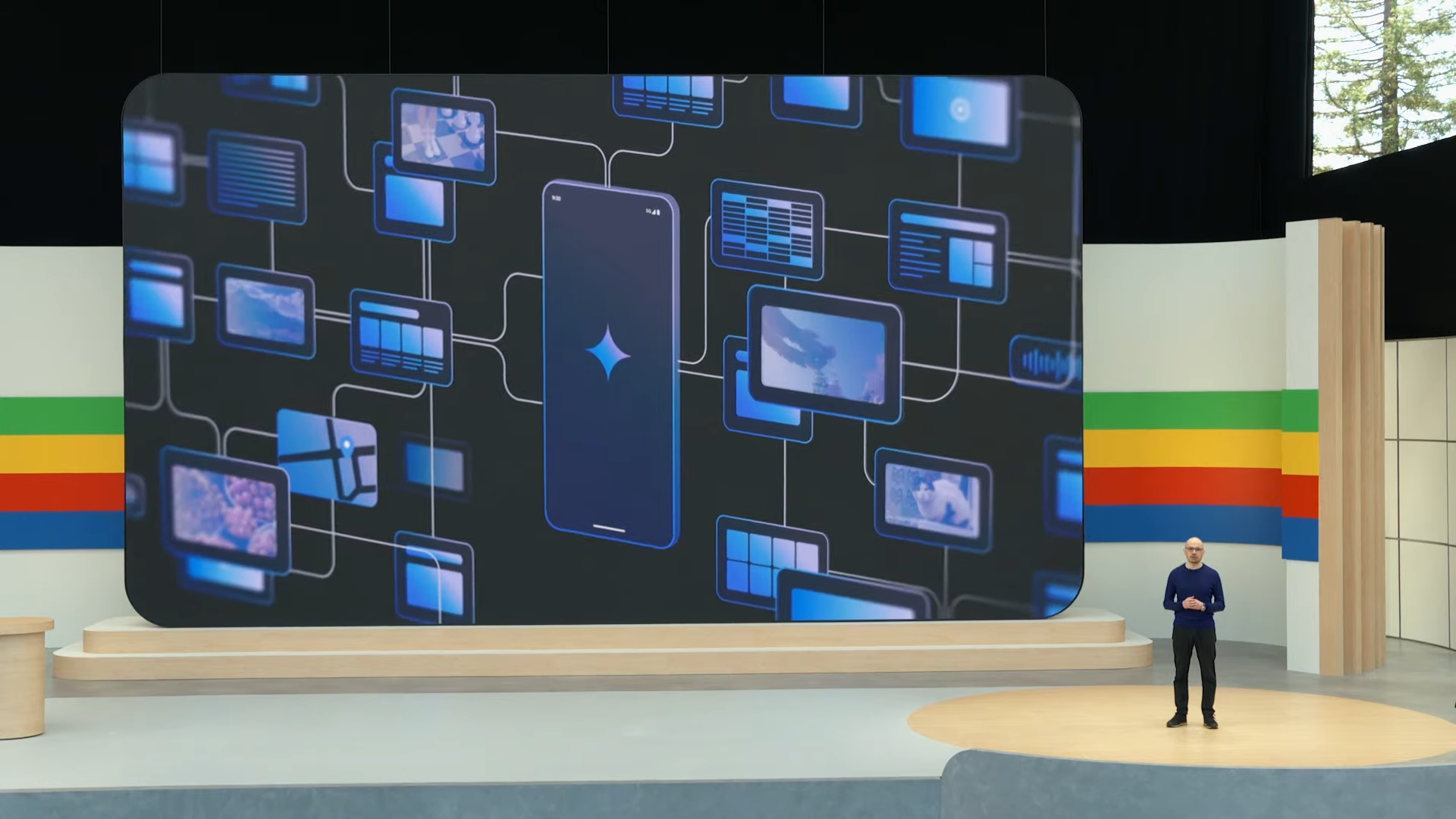

Agenci AI i niezwykły Project Astra

Gemini może służyć użytkownikom w codziennych czynnościach. Tak zwani Agenci AI będą mogli wykonywać niektóre rzeczy za nich. Na przykład wystarczy, że posiadacz smartfona zrobi zdjęcie butów, które zechce zwrócić do sklepu. Proces będzie organizowany przez AI, ściągając z użytkownika konieczność przebijania się przez formularze i regulaminy, by dowiedzieć się, jak to dokładnie zrobić. Funkcje te będą pomagać też planować dzień czy wyszukiwać miejscówki na wakacje.

Chyba najciekawszym elementem prezentacji był Project Astra. Jego założeniem jest to, by dać Gemini oczy. Dzięki kamerze w naszym smartfonie, sztuczna inteligencja będzie mogła widzieć i rozpoznawać otoczenie użytkownika oraz zgromadzone w nim przedmioty. Wszystko to możliwe jest na żywo, podczas prowadzenia naturalnego dialogu – bez opóźnień, które kojarzą się z klasycznym Asystentem. Niestety, wygląda na to, że opcje te będą – przynajmniej na razie – dostępne tylko w USA. Kolejne kraje mają być dołączone „wkrótce”. Plan jest taki, by miliard użytkowników mógł korzystać z tej nowości we własnym kraju do końca 2024 roku.

Google udostępnia też narzędzia do generowania obrazów, muzyki i filmów. Grafiki będą znacznie bardziej szczegółowe dzięki ulepszonemu modelowi Imagine 3, a filmy tworzone będą przy pomocy oprogramowania nazwanego Veo.