Androidy nie śnią o elektrycznych owcach – one wyobrażają sobie, jak jedne kształty zamieniają się w inne, zmieniając przy tym dynamicznie barwy przy akompaniamencie niepokojących zlepków dźwięków. Tak, Sztuczna Inteligencja nie radzi sobie zbyt dobrze z interpretacją i tworzeniem własnej impresji rzeczywistości.

Artysta i inżynier Alexander Reben postanowił wykorzystać inteligentne algorytmy, by te, bazując na mechanizmach uczenia maszynowego stworzyły własny zlepek obrazów i dźwięków. W rezultacie powstało doprawdy dziwne wideo, które pozostawia nas z pytaniem: „Dokąd zmierza Sztuczna Inteligencja?”.

Wiele moich prac dotyczy związku między technologią a ludzkością. Staram się zrozumieć, gdzie może nas poprowadzić jej rozwój. Zadałem sobie pytanie: co by było, gdyby AI patrzyło na materiały Bobba Rossa, będąc na wirtualnym LSD?

– Alex Reben

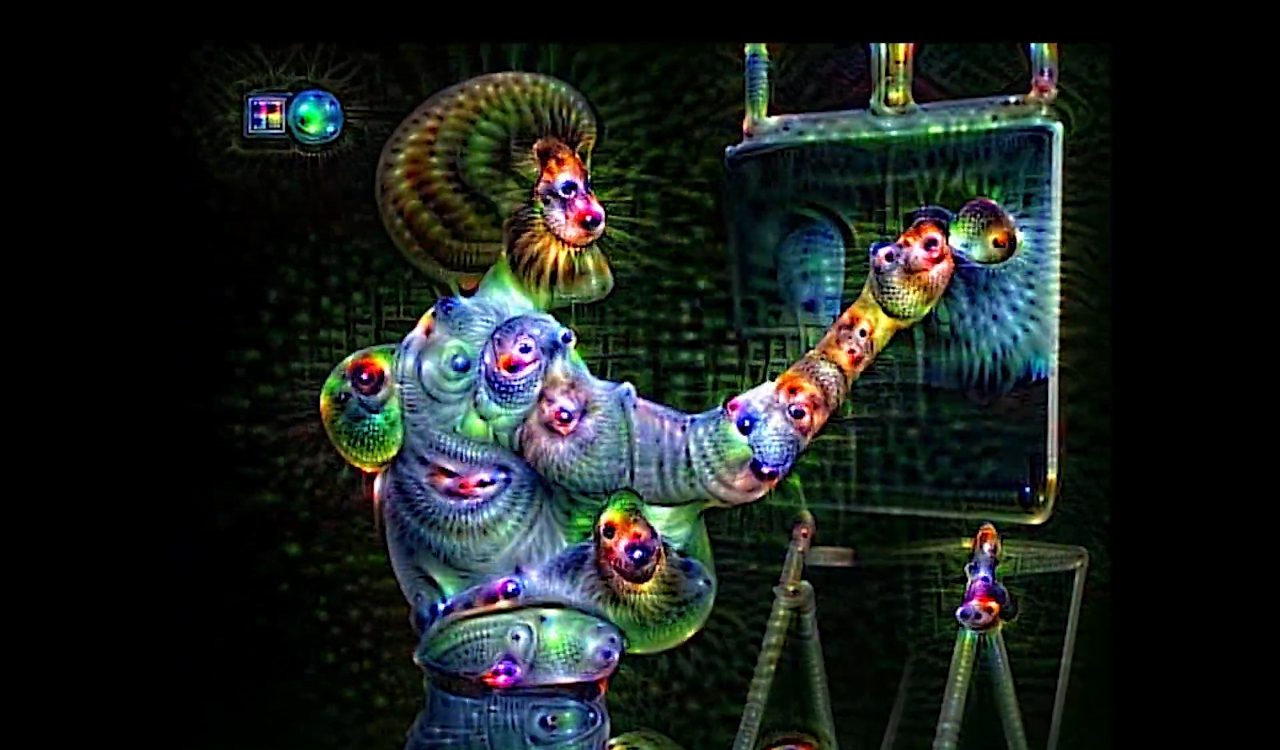

Rzeczywiście, w efekcie długiego „przerabiania” przez algorytmy filmów Bobba Rossa, który swego czasu prowadził w amerykańskiej telewizji serię programów dotyczących podstaw malarstwa, powstał klip przyprawiający o gęsią skórkę. Algorytmy przez miesiąc uczyły się tego, co pojawiało się na ekranie oraz zbierały dane dźwiękowe. Następnie miały wygenerować własny materiał. Jak można się było spodziewać, jest on zbliżony do oryginału, ale występują w nim ewidentne różnice.

Obraz zachowuje kontury występujące w źródłowych klipach, jednak pojawiają się w nich kolejne elementy, jak w kalejdoskopie. Algorytm ewidentnie czuł potrzebę wypełniania kadru wszystkim, co się da – wszystkim, czego nauczył się wcześniej. Dotyczy to też dźwięku: nie ma w nim pauz, a bardziej przypomina jakąś taśmę puszczoną od tyłu niż jakąkolwiek sensowną muzykę czy mowę.

Reben od dawna eksperymentuje z algorytmami. Jego wcześniejsze próby obejmowały szkolenie sieci neuronowych do naśladowania stylu wypowiedzi różnych gwiazd polityki i showbiznesu.

Do klipu wideo Reben użył parę algorytmów uczenia maszynowego, udostępnianych przez Google (Deep Dream) i VGG. Można je szkolić, przez wstępne zaprezentowanie algorytmowi serii odpowiednio oznaczonych zdjęć. Sztuczna Inteligencja przypisuje je do poszczególnych kategorii, a następnie, metodą porównań, rozwija je. Im większa pula znajdzie się w początkowym zestawie treningowym, tym dokładniej będzie działać sieć neuronowa.

W przeciwieństwie do takich systemów jak Captionbot od Microsoftu, Deep Dream nie tylko interpretuje to, co znajduje się na obrazie i przypisuje do niego tagi, ale też próbuje samemu pokazać, co według algorytmu na nim widać. Stąd na wideo pojawiają się dziwne „obrazy w obrazie”, wkomponowane w oryginalne kształty i postacie.

Te filmy i dźwięki są mocno abstrakcyjne. Dziwnie można się poczuć ze świadomością, że jest to materiał w całości „wyprodukowany” przez Sztuczną Inteligencję, nawet jeśli powstał tylko drogą pewnej modyfikacji źródeł.

źródło: Endgadget