Postęp to wieczny wyścig. Lepszy procesor, szybsza pamięć, większa bateria. Niegdyś przełomy następowały co kilka lat, dziś co pół roku, co kwartał, co miesiąc mamy „rewolucję” – nowe, naszpikowane najnowszymi rozwiązaniami flagowce. Tylko że my wcale tego nie potrzebujemy. Chcemy coś starego, co będzie dobrze działać.

Nic dziwnego, że nikomu poza Stevem Jobsem nie wpadło do głowy, że ekran dotykowy to coś, czego ludzie zapragną na zabój. Inaczej. Pomyśleli o tym inni przed Jobsem, ale ich rozwiązania się nie przyjęły. Można wskazywać na wcześniejsze pomysły, choćby Nokii i jej model 7700, który nigdy nie ujrzał światła dziennego. Dlaczego? Jobs był czarodziejem designu i pomysłu – powiedzą jedni. Świetny marketing i lep ekskluzywnej marki, jaką jest Apple – powiedzą drudzy. Odwaga i szczęście – powiedzą inni.

A może to po prostu splot tego wszystkiego plus czas, w którym technologia dotykowa w końcu dorosła? Przestała być gadżetem dla upartych, a stała się prosta i przyjemna? Może musiał do niej dorosnąć system operacyjny? A może…

Może to my musieliśmy wyrosnąć z komfortu używania urządzeń, które znamy tak dobrze, że nie potrzebujemy nic więcej? Przecież na co dzień używamy urządzeń, w których rozwiązania technologiczne mają kilka, kilkanaście. lub kilkadziesiąt lat. I wcale nie narzekamy, że są przestarzałe. Wręcz odwrotnie – utyskujemy zazwyczaj, że w nowych wersjach niepotrzebnie psuje się coś, co dobrze działało przez lata!

Ma być lepsze? Wsadźmy do tego komputer!

Doskonale widać to na przykładzie samochodów osobowych. Komputery masowo trafiły do aut pod koniec lat 80 (choć próby były już 10 lat wcześniej wcześniej – komputer podróżny w Cadillacu Seville). Wszystko po to, by ograniczyć spalanie, uekologicznić pojazdy oraz uczynić podróżowanie bezpieczniejszym. Elektronika steruje więc spalaniem, zapewniając najwydajniejszą i najoszczędniejszą w danej chwili mieszankę paliwa z powietrzem i idealnie dobrany punkt jej zapłonu; zarządza układem jezdnym, zapobiegając blokowaniu się kół podczas gwałtownych manewrów i dopasowując rozłożenie napędu na poszczególne osie, czy koła; kontroluje skrzynię biegów; steruje układami bezpieczeństwa (napinacze pasów czy poduszki powietrzne). Oczywiście jest też wykorzystana zupełnie banalnie, w kontroli klimatyzacji, wspomaganiu parkowania, wyświetlaniu parametrów jazdy na szybie, czy choćby doświetlaniu zakrętów. Całym tym mnóstwem rzeczy (za wyjątkiem poduszki i pasów) zarządza centralny komputer, w którym możemy dopasować np. styl jazdy, jaki planujemy – powoduje to zmiany predefiniowanych ustawień. I voila! Auto z dostojnego sedana rodzinnego zmienia się w drapieżnego speedstera, którym z rykiem i piskiem opon ruszamy na światłach pod żeńskim akademikiem.

Teoretycznie. Najczęściej ustawień nie da się zmodyfikować, a jedynie przełączyć (jak to jest wkurzające – wie każdy, kto kiedyś korzystał z predefiniowanego equalisera w odtwarzaczu audio – nigdy nie pasuje do człowieka!). Oznacza to, że i człowiek, i auto są (dla bezpieczeństwa) sztucznie ograniczani. Popularny showman i autor programu Top Gear – Jeremy Clarkson najczęściej w swych programach obśmiewa doszczętnie tę filozofię i tzw. „ustawienia sportowe” komputera jazdy, wskazując, że jest to raczej taki sport dla wygodnych, starszych panów z drinkiem w dłoni.

No, ale Clarkson w ogóle nie lubi ograniczeń.

Trudno obecnie kupić nowe auto pozbawione tego typu usprawnień. Więcej – jeżdżą już auta sterowane systemami znanymi z urządzeń mobilnych, np. Androidem. Ale czy jesteśmy z nich bardziej zadowoleni, niż z aut sprzed ery komputeryzacji wszystkiego? Są niewątpliwie nowocześniejsze, mają wyświetlacze, przyciski, reagują na dotyk, głos, ale czy cieszą bardziej? Niekoniecznie. Fora fanów motoryzacji zapełniają utyskiwania na elektronikę, która uczyniła naprawy aut znacznie kosztowniejszymi, a wąsatego mechanika utytłanego w smarach zmieniła w faceta w czystym kombinezonie, który podłącza kabelki do auta i laptopa, a potem wymienia gotowe „cegiełki” – komponenty. Samochody w zasadzie już teraz są tym, co wkrótce będziemy nosić w kieszeniach – projektem ARA.

Owszem, nowe silniki sterowane komputerowo są o wiele wydajniejsze i ekonomiczniejsze, ale gdyby to zależało od ludzi, najchętniej większość wywaliłaby taki nowoczesny w diabły, w zamian wsadziła poczciwy, prosty silnik z połowy lat 80. Bo ma świece, cylindry, tłoki, miskę olejową, przewody – i już. Bo jest mniej awaryjny, bo można go podrasować, bo sztucznie nie poskramia człowieka. I ładnie ryczy na wysokich obrotach.

Nie wydaje się to dziwne. Elektroniczne dławiki są montowane w wielu sprzętach. Obecnie np. w smartfonach jest sztucznie zaniżana głośność przekazywana na słuchawki. Wszystko z powodu prewencyjnej ochrony słuchu użytkownika. Tyle, że ten użytkownik często wolałby sam zdecydować, czy dziś akurat ma ochotę chronić swój słuch, czy też potrzebuje poczuć, jak krew płynie mu z uszu. Wielu fanów muzyki twierdzi, że urządzenia mobilne są po prostu za ciche – więc stosuje wzmacniacze pomiędzy urządzeniem, a słuchawkami.

A komputery czuwają nie tylko w samochodach. Znajdziemy je też w lodówkach, pralkach, zmywarkach, kuchenkach mikrofalowych… Sterownikach oświetlenia, klimatyzatorach, ogrzewaczach wody. Nawet w ustępach (no tak, w Japonii wszystko jest możliwe). Cyfrowy dom zbliża się wielkimi krokami. Wszędzie chipy i kontrolki zaprogramowane przez mądrych ludzi w Chinach czy na Tajwanie dbają o nasze zdrowie, zabezpieczając przed zrobieniem czegoś tam, czego nie powinniśmy robić. Dbają o ekologiczność, dobierają idealnie opracowane parametry prania, mrożenia, grzania, wirowania, odsysania, parkowania, naświetlania, budzenia, mycia, dozowania mydła i czegokolwiek innego.

I przy okazji nie dopierając jednak ubrań, niedomrażając żywność, nie dając zadowolenia z jazdy autem.

Bo my nie cierpimy komputerów poza biurkiem i kieszenią.

Komputer? Tak, ale aby nie za nowy

Jest dziedzina, w której postęp jest wręcz sztucznie powstrzymywany. Dziedzina, w której używa się technologii sprzed kilku – kilkunastu lat, chociaż obecna zajęłaby mniej miejsca i uczyniła całość “ekologiczniejszym”. To technologia lotów kosmicznych. Komputery w statkach kosmicznych!

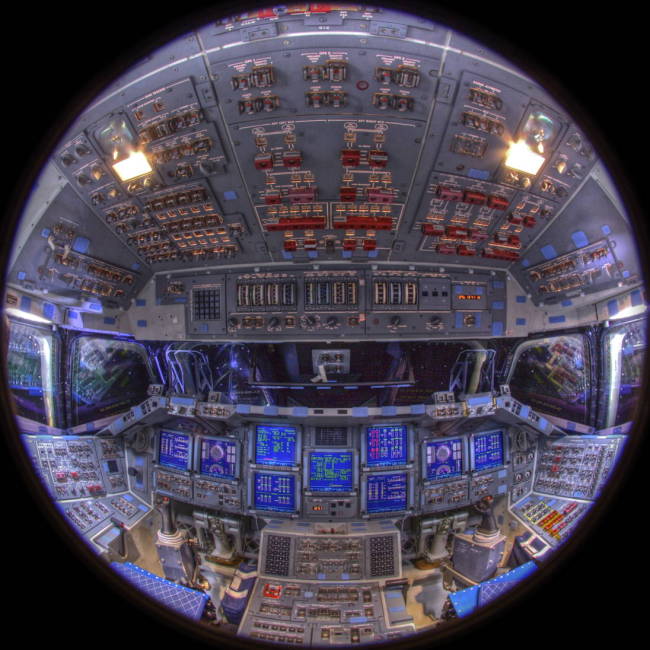

Z filmów SF mamy jakieś przekonanie, że we wnętrzu statku kosmicznego są ogromne ekrany, konsole dotykowe lub wirtualne, sterowanie głosem, myślą, mową, uczynkiem, czy innym zadbaniem… Że w kosmosie są najnowsze technologie. Że kosmos to pole doświadczalne, po którym dopiero dostajemy w ręce wynalazki, którymi kosmonauci bawili się 5 lat temu. Nieprawda.

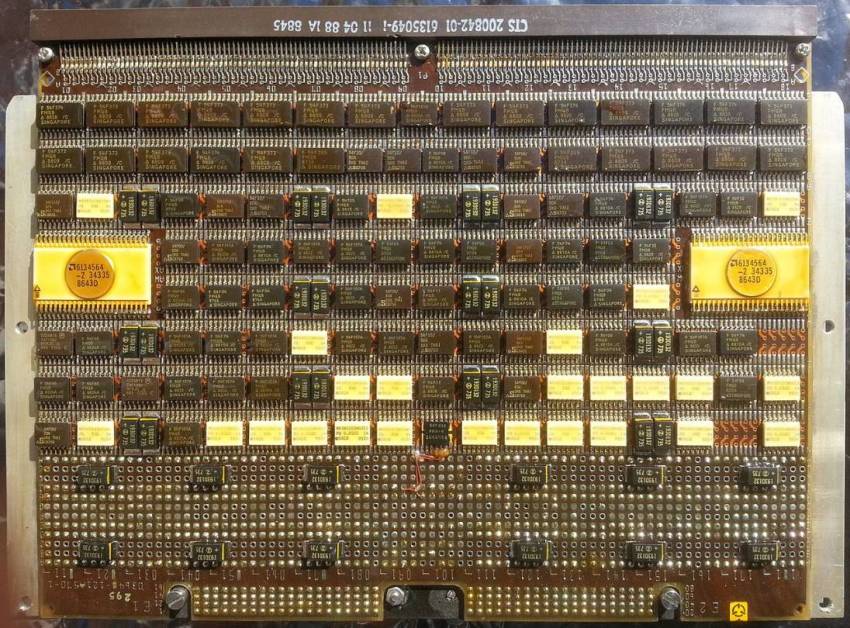

W maju roku roku 2000 w misji wahadłowca Atlantis (STS-101) wprowadzono najnowocześniejszy we wszystkich dotychczasowych promach kosmicznych komputer sterujący awioniką IBM AP-101S. Wymusiło to zastosowanie ztw. “szklanego kokpitu”, czyli systemu wielofunkcyjnych wyświetlaczy, które zastąpiły tradycyjne wskaźniki mechaniczne (“zegary”). Dlatego sercem komputera został procesor Intel 80386 z ok. 1MB CMOS – mieścił tam całe oprogramowanie potrzebne do zarządzania promem. 1 MB to było dwa razy więcej, niż dotychczas, przez co programiści mogli wprowadzić mnóstwo programów zapasowych. Na dodatek procesor zapewniał wydajność na poziomie 1,2 miliona operacji na sekundę, kilkadziesiąt procent więcej, niż poprzedni, montowany w promach AP-101F! Oczywiście prom kosmiczny nie może polegać na jednym komputerze, dlatego jest ich łącznie pięć – 4 robią symultanicznie te same obliczenia a piąty testuje je co chwilę.

Procesory serii 80386 powstały w 1985 roku, a okres ich popularności w desktopach to lata 90. W roku 2000 na rynku były już nowoczesne procesory Intel Pentium 3 o wydajności kilkaset razy większej, niż jednostka montowana (i używana aż do ostatniego lotu wahadłowca w 2011 roku!) w Atlantis. Tyle, że proces budowy i programowania komputera AP-101S trwał 3 lata, a testowania kolejne 3…

Na Międzynarodowej Stacji Kosmicznej, która powstawała od 1998 roku, zamontowano nowocześniejsze komputery – jednostki z zupełnie normalnymi procesorami 80386SX-20s (minimalnie 2,5 miliona operacji/sek) oraz nieco szybszymi, nie stosowanymi w desktopach 80387. W sondach kosmicznych, teleskopach i innych urządzeniach wysyłanych w kosmos stosuje się nowsze procesory, np. w teleskopie Hubble’a komputer działa w oparciu o procesor 80486. W sondzie Rosetta zaś, wystrzelonej w 2004 roku (to ta, która miała swe chwile w mediach kilka tygodni temu) zainstalowano komputer z 16-bitowym procesorem Dynex MAS31750 o prędkości 25MHz. Demon prędkości, prawda? A w 2004 roku w komputerach domowych montowano już od dawna Pentium 4.

Są to wszystko okropnie przestarzałe, ale bardzo dobrze znane i sprawdzone jednostki, które muszą pobierać niewiele mocy i muszą być doskonale zabezpieczone np. przed promieniowaniem kosmicznym. Proces konstruowania i testowania takiego komputera trwa wiele lat, z natury rzeczy nie może to być zatem “nowinka techniczna” a technologia sprzed 10-20 lat.

Uwaga – astronauci w wahadłowcach i na stacjach kosmicznych używają do kontroli urządzeń zewnętrznych (pomiarowych) laptopów, ale są to specjalnie zmodyfikowane wersje, z baterią litową zmienioną na inną (alkaliczną). Na dodatek laptopy zmienia się na nowe po każdej misji (czyli co maksymalnie 5 miesięcy). Wychodzi na to, że jednym laptopem dałoby się obsłużyć awionikę i nawigację kilkudziesięciu promów kosmicznych. Ale się tego nie robi. Choćby dlatego, że komputer pokładowy AP-101S ma bezawaryjność minimum 10 tys. godzin pracy. A laptop? Według badań, laptopy psują się 20 x częściej, niż samochody…

Nowe nie zawsze znaczy lepsze

Używamy na co dzień urządzeń, wobec których 10 lat temu zachowywalibyśmy się jak dzicy, a 5 lat temu nie nadążylibyśmy za nimi. Pierwszy iPhone miał 3,5 calowy ekran, najnowszy ma już 6 cali. Tablety z Androidem sprzed 4 lat nie umywają się do najnowszej Nokii N1 czy Nexusa 9. Ale… Z zazdrością patrzyłem na kolegę, który po tym, jak zepsuł mu się jego smartfon, kupił sobie Nokię 206, która trzymała mu na baterii… Tydzień. Z rozrzewnieniem wspominamy stare Sony Ericssony i Nokie, które mogły dowolnie upadać na beton i nic im się nie działo, a jeśli już, to samemu zmieniło się im obudowę za 20 zł, czy wymieniło wyświetlacz. I które – gdy się je utopiło w toalecie – nie kosztowały tyle, co średnia pensja w Polsce, a około 300-500 złotych.

I częstokroć jako telefony były o wiele wygodniejsze i lepsze.

Obecnie najwięksi producenci sprzętu mobilnego wypuszczają nowości co pół roku. Często są to urządzenia pełne błędów, które pracowicie w późniejszych miesiącach poprawia się poprzez aktualizacje. Tyle, że producent w chwili premiery flagowca pracuje już nad nowym i nie chce poświęcać za dużo uwagi temu, który już jest na rynku. Często wypasione urządzenie sprzed roku przestawało być wspierane, co popełniało zarówno LG, jak i HTC. Features, którymi dopycha się marketingowo nowe sprzęty, są częstokroć zupełnie niepotrzebne (na co często wskazują użytkownicy Samsungów), albo po prostu źle działają (przykład czytnika linii papilarnych w HTC One Max). W efekcie nowy tablet, smartfon, laptop, czy pecet, zamiast być naprawdę szybszymi i wydajniejszym (co obiecują wszelkie porównania techniczne – bardzo konkretnymi cyferkami – tu 30% więcej mocy, tam 20% więcej czegoś tam) od poprzedniego, są wciąż drażniące zacięciami oprogramowania wynikającymi z pośpiechu, czy głupimi oszczędnościami na kamerze, przetworniku dźwięku, czipie komunikacji GSM/3G/LTE, czy głośniku.

Chyba wszyscy tęsknimy jednak do porządnie wykonanych urządzeń z technologią może i sprzed roku, czy dwóch, ale za to przemyślanych i przetestowanych. Dopracowanych. Bez upierdliwych baboli, które znajdzie każdy po kilku dniach testowania, czy zwykłego użytkowania. Dopasowanych do każdej sytuacji. Nie denerwujących ani niedoróbkami, ani niepotrzebnymi blokadami ze strony oprogramowania.

Przez lata Apple robił coś w tym kierunku właśnie, ale i Apple dołączył do wyścigu postępu. W wyniku tego teraz jest duży i nowoczesny, ale za to potrafi się wygiąć. No cóż…

A przecież, jak pisał Blaise Pascal – Wszystko, co doskonali się dzięki postępowi, także ginie od postępu.

Jakiego tabletu używałby major Tom, bohater najsłynniejszej, „kosmicznej” piosenki napisanej przez Davida Bowiego? Przez jaki smartfon rozmawiałby z kontrolą naziemną w 1969 roku? A jakich używał rok temu Chris Hadfield? Prawie tych samych. Prawie…